支撑人工智能应用的硬件引擎

最后再介绍一下人工智能芯片。前面已反复指出,大数据和人工智能芯片是两个基础点,可以说支撑了人工智能技术与产业的迅猛发展。前面的报告介绍了Hadoop、Spark和Petuum等高性能分布式CPU/GPU集群系统的研究。

作为支撑人工智能应用的硬件引擎,我想强调如下三个方面的应用:一是基于超级GPU或者TPU集群的离线训练,这是必不可少的。比如说训练1000个小时、2000个小时,用了这个超算系统后10分钟可能就解决问题了,这是一定要有的,但这块主要依赖于GPU和TPU,功耗太高、成本太贵。例如2000块GPU大致需要1个亿的投入。二是基于云平台的在线应用,这可以用FPGA来做,既可以降低成本,也可以大幅减少功耗。三是直接进行终端应用。

在超级GPU或者TPU集群服务器方面,英伟达(Nvdia)的深度学习芯片Tesla P100,具有150亿个晶体管,运算速度达到21.2万亿次,研发预算超过20亿美元。利用P100构建的超级计算机DGX-1速度达到170万亿次。因为卷积神经网络本质上是张量(Tensor)处理,Google数据中心研发的张量处理器(TPU),是它的秘密武器。它对CPU计算能力要求不高,是专门为深度学习定制的ASIC。无论是GPU还是TPU,我们中国企业的机会不多,技术门槛太高。实际上,GPU或TPU的成本太贵,功耗太高。我们的机会就在FPGA上面,也就是进行基于FPGA的深度学习芯片(DPU)的研发。相对于GPU。不但灵活度更高,成本很低,而且其能耗比可提升至少1000倍。对于基于云平台的在线应用或者移动端应用,拿FPGA来做,它的成本、功耗、体积都有很大的优势,这或许是我们惟一能够做的事情。

还有一类功耗更低,且更有前瞻性的是类脑芯片。包括两种类型:一是利用传统CMOS工艺进行生物突触模拟,就是用几个晶体管去模拟突触连接权;二是直接使用新型忆阻器件去模拟生物突触。IBM的TrueNorth和高通的Zeroth是前一类神经形态芯片的典型代表。

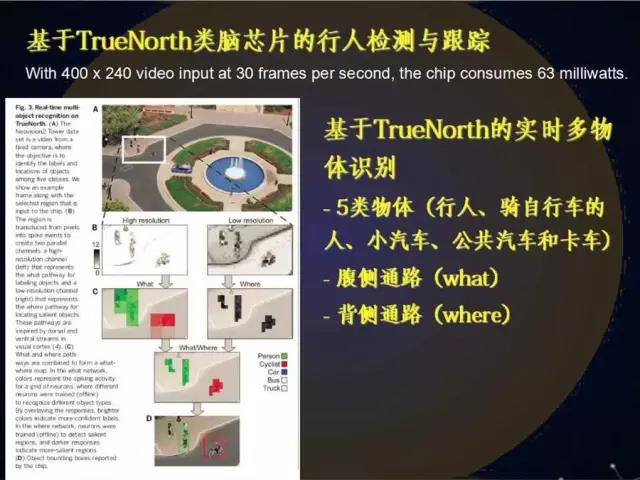

IBM的TrueNorth,2014年8月发表在《科学》杂志上。它有什么特点呢?这个芯片里面有100万个发放神经元,模拟了2.56亿突触连接。人脑的神经元就是发放的,可以理解为很多个脉冲。以前觉得发放神经元没有什么用,现在发现由它组成的神经网络,功耗很低,TrueNorth类脑芯片才只有63个毫瓦!我们知道人脑的全部功耗只有区区20瓦,但皮层神经元的个数却有140亿。IBM最近还有一个实验,它使用48块TrueNorth芯片构建了一个小型数字化鼠脑,相当于有4800万个发放神经元,这个数字化的鼠脑可以进行深度学习,可以识别图片和语音,也可理解一些自然语言,还可通过在线增量学习以适应新环境。

除此之外,还有一个更新的、比IBM和高通类脑芯片功耗更低的基于忆阻器的类脑芯片。忆阻器也叫记忆电阻,是硬件模拟生物突触的理想方式。简单说,忆阻器随流经的电荷的变化其阻值就会发生变化,而且在断流时还具有阻值记忆功能。1971年提出忆阻器设想,2008年的时候惠普用纳米薄膜把它制备成功了。最新的结果是2015年加州大学等研制了一款基于Crossbars的忆阻类脑芯片,发表在2015年5月的《自然》杂志上。它的特点是集成度更高,读写速度更快,尤其是功耗会更低更低。当然前面和后面这两类人工智能芯片,技术门槛特别高,我们能做的事情可能不多。

最后是三句话的结语。第一,弱人工智能的产业发展正处于爆发期,大家可以开始做工程化的应用产品开发了,深度卷积神经网络确实是非常大的进步,尤其是得到大数据和超强计算能力的支撑。第二,即使是深度卷积神经网络的一点点进步,也会给人类社会进步带来巨大的变革。第三,私有大数据和深度学习芯片是制胜的关键和法宝。

【作者介绍】邓志东,1991年获哈工大博士学位。2000年起担任清华大学计算机系教授,博士生导师。兼任中国自动化学会理事,中国自动化学会智能自动化专业委员会主任。曾任国家863计划智能机器人主题专家组组长助理(1998-2001)。目前的研究方向:人工智能、深度神经网络、计算神经科学,先进机器人、无人驾驶汽车等。曾从事的研究领域:虚拟现实(1998-2001)、无线传感器网络(2001-2009)、计算生物学(2002-2010)。